چند سال پیش اگر می گفتید یک برنامه کامپیوتری می تواند نقاشی بکشد، شعر عاشقانه بنویسد، سرطان را از روی عکس تشخیص دهد یا حتی با شما مثل یک دوست واقعی حرف بزند، احتمالا به شما می خندیدند و می گفتند «این ها فقط در فیلم های علمی تخیلی ممکن است». اما امروزه همه این ها نه تنها ممکن شده، بلکه بخشی از زندگی روزمره میلیون ها نفر در سراسر جهان است؛ راز پشت این جهش خیره کننده شبکه های عصبی هستند.

شبکه های عصبی، قلب تپنده هوش مصنوعی مدرن هستند؛ دستیارهای صوتی گوشی و خودروهای خودرانی که در خیابان های تهران و کالیفرنیا حرکت می کنند، چت بات هایی که شبانه روز به سوالات شما جواب می دهند، حتی سیستم هایی که در بیمارستان ها جان انسان ها را نجات می دهند، همگی روی لایه های بیشماری از نورون های مصنوعی سوار شده اند که با سرعتی باورنکردنی از تجربه هایشان یاد می گیرند.

در این مقاله فقط یک متن خشک علمی نیست، می خواهیم با هم سفری داشته باشیم از صفر تا صد مفهوم شبکه های عصبی؛ از اینکه اصلا شبکه عصبی چیست و چرا به آن «عصبی» می گویند، تا جدیدترین کاربردهایش در یک سال اخیر و اینکه چطور همین امروز در حال تغییر دادن جهان هستند. اگر کنجکاوید بدانید چرا یک عکس ساده از گربه می تواند میلیاردها پارامتر عددی را به حرکت درآورد، یا چرا یک مدل زبانی مثل من می تواند فارسی روان بنویسد و حتی شوخی کند، تا آخر این مقاله با ما بمانید.

چون آینده دیگر در راه نیست؛ همین جا، زیر انگشتان ما، با هر بار فشردن کلید Enter در یک مدل شبکه عصبی در حال ساخته شدن است؛ بیایید با هم ببینیم این جادو چگونه کار می کند.

شبکه های عصبی هوش مصنوعی چیست؟

اگر امروز از هر متخصصی بپرسید «هوش مصنوعی چطور کار می کند؟»، احتمالا در جایی از جوابش اصطلاح «شبکه های عصبی» را خواهید شنید. اما شبکه های عصبی هوش مصنوعی دقیقا چیستند و چرا اینقدر مهم شده اند؟

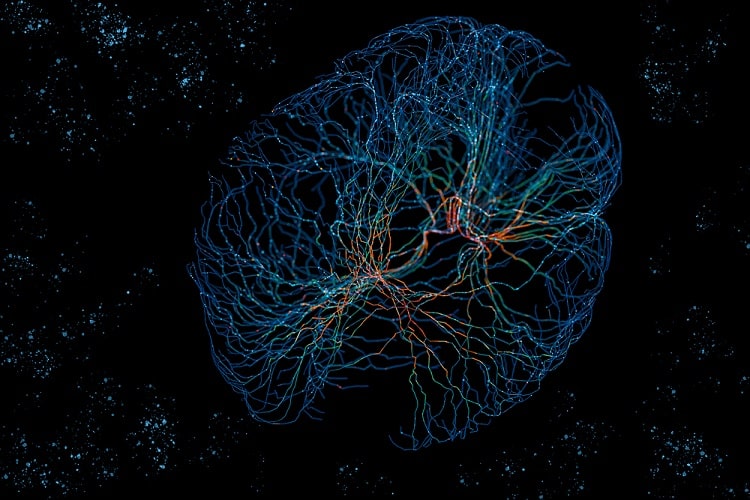

شبکه های عصبی مصنوعی (Artificial Neural Networks) که در زبان انگلیسی به اختصار ANN یا просто Neural Networks نامیده می شوند، در اصل تلاش بشر برای شبیه سازی نحوه ی کار مغز انسان، البته به شکلی بسیار ساده شده هستند. همانطور که میدانید، مغز ما از میلیاردها نورون تشکیل شده که با ارسال سیگنال های الکتریکی و شیمیایی به یکدیگر، یاد می گیرند، تصمیم می گیرند و خلاقیت به خرج می دهند. شبکه های عصبی هوش مصنوعی هم دقیقا همین ایده را دنبال می کنند؛ یعنی تعداد زیادی «نورون مصنوعی» که با وزن ها و بایاس های عددی به هم متصل شده اند و از طریق داده های آموزشی یاد می گیرند الگوهای پیچیده را تشخیص دهند.

این نورون های مصنوعی در لایه های مختلف قرار می گیرند، لایه ورودی که داده خام (مثل پیکسل های یک عکس یا کلمات یک جمله) را دریافت می کند، چندین لایه ی مخفی که جادوی اصلی در آن ها اتفاق می افتد، و در نهایت لایه ی خروجی که جواب نهایی را می دهد؛ مثلا «این عکس یک گربه است» یا «این جمله احساس مثبت دارد».

در واقع، آن چه شبکه های عصبی را از روش های قدیمی یادگیری ماشین جدا می کند، توانایی شگفت انگیزشان در «یادگیری نمایشی» (Representation Learning) است. یعنی به جای اینکه ما به صورت دستی ویژگی ها را استخراج کنیم (مثلا بگوییم لبه، گوشه، رنگ و…)، شبکه خودش یاد می گیرد که کدام ترکیب از پیکسل ها مهم است. همین ویژگی باعث شده که از اوایل دهه ی ۲۰۱۰ تا امروز، تقریبا تمام پیشرفت های بزرگ هوش مصنوعی، از تشخیص تصویر تا چت بات های امروزی، همگی روی شانه های شبکه های عصبی سوار باشد.

شبکه های عصبی به انگلیسیNN چیست؟

شبکه های عصبی به انگلیسی، Neural Networks یا به اختصار NN نامیده می شوند. در مقالات علمی و کدهای برنامه نویسی معمولا با نام Neural Networks یا به صورت مخفف NN و وقتی حرف از یادگیری عمیق باشد Deep Neural Networks (DNN) مواجه می شوید. در واقع، اصطلاح «عمیق» (Deep) به تعداد لایه های مخفی اشاره دارد. هرچه لایه ها بیشتر باشد، شبکه عمیق تر و معمولا قدرتمندتر می شود؛ البته این به قیمت نیاز به داده و قدرت محاسباتی بیشتر است.

انواع شبکه های عصبی در هوش مصنوعی

انواع شبکه های عصبی در هوش مصنوعی وجود دارد که یکسان ساخته نمی شوند. همانطور که مغز انسان بخش های متفاوتی برای دیدن، شنیدن و صحبت کردن دارد، در هوش مصنوعی هم برای هر نوع مسئله، معماری خاصی طراحی شده است. شناخت این انواع مثل داشتن جعبه ابزار کامل یک نجار می ماند؛ هر ابزار برای کار خاصی ساخته شده است.

شبکه های پرسپترون چندلایه (MLP) ساده ترین و قدیمی ترین نوع هستند و هنوز هم برای مسائل تبلور (مثل پیش بینی قیمت خانه) استفاده می شوند. اما وقتی صحبت از تصویر می شود، شبکه های کانولوشنی یا CNNها سلطان بلامنازع اند. در حقیقت، شبکه های بازگشتی (RNN) و به ویژه LSTM و GRU برای داده های ترتیبی مثل متن و صدا ساخته شدند.

جالب است بدانید، در سال های اخیر، معماری Transformer، تقریبا همه چیز را زیر و رو کرد و پایه ی مدل های زبانی بزرگی مثل GPT، Gemini و LLaMA شد؛ حالا حتی برای تولید تصویر هم با Diffusion Models و GANها طرف هستیم که خودشان نوعی شبکه عصبی پیشرفته هستند.

کاربرد شبکه های عصبی در هوش مصنوعی ۲۰۲۶

۱- شبکه های عصبی گراف (GNN) و کشف مواد جدید

۲- هوش مصنوعی عامل محور (Agentic AI) و مدیریت خودکار

۳- شبکه های عصبی فیزیکی و رباتیک تطبیقی

۴- رویکردهای نمادین–عصبی (Neuro-Symbolic AI) در پژوهش علمی

۵- شبکه های عصبی لبه ای (Edge AI) و تحلیل داده در لحظه

- مدیریت ترافیک شهری و تنظیم زمان چراغ ها بر اساس داده های لحظه ای

- تحلیل ویدیو در دوربین های امنیتی بدون ارسال داده به سرور

- سیستم های پایش انرژی و کنترل مصرف در ساختمان های هوشمند

کدام نوع شبکه عصبی برای چه داده ای مناسب است؟

- پزشکی

- تشخیص بیماری از تصاویر رادیولوژی

- تحلیل الگوهای ژنتیکی

- پیش بینی نتایج درمان

- وسایل نقلیه خودران

- تحلیل محیط با CNN و Transformer

- پیش بینی مسیر خودروها و عابران

- تصمیم گیری لحظه ای برای حرکت ایمن

- مالی

- تحلیل ریسک اعتباری

- شناسایی تراکنش های مشکوک

- پیش بینی نوسانات بازار

- کشاورزی و محیط زیست

- تشخیص بیماری گیاهان با مدل های تصویری

- پیش بینی وضعیت خاک و آبیاری

- تحلیل داده های پهپادها برای مدیریت مزرعه

- محتوای مولد (Generative AI)

شبکه های عصبی هم اکنون، از مرحله کاربردهای محدود عبور کرده و به ابزار اصلی توسعه سیستم های هوشمند در حوزه های صنعتی، علمی و شهری تبدیل شده اند. به طوری که شاهد این هستیم که مدل های تخصصی مانند GNN، Agentic AI، Edge AI و Neuro-Symbolic در حال حاضر، نقش پررنگی در افزایش دقت، کاهش مصرف انرژی و توسعه ی راه حل های قابل اتکا ایفا می کنند.

آینده شبکه های عصبی در سال ۲۰۳۰

سال ۲۰۲۵ فقط آغاز راه بود؛ تا سال ۲۰۳۰، آینده شبکه های عصبی از ابزارهای تخصصی به زیرساخت جهانی تمدن تبدیل خواهند شد. مهمترین روندهایی که همین امروز در آزمایشگاه ها در حال شکل گیری هستند عبارتند از:

- مدل های چندوجهی یکپارچه (Unified Multimodal Models): دیگر مدل جدا برای متن، تصویر، صدا و ویدیو نخواهیم داشت؛ یک مدل واحد همه را همزمان درک و تولید می کند. پروژه هایی مثل Chameleon، ImageBind و اکنون مدل های ۲۰۲۵ مانند Gemini-2 و GPT-5 مسیر را هموار کرده اند.

- یادگیری کارآمدتر و سبزتر: مدل های ۲۰۳۰ با ۱۰۰ برابر کارایی انرژی بیشتر نسبت به امروز کار خواهند کرد. تکنیک هایی مثل Sparse Activation، Mixture-of-Experts و Quantization به بلوغ می رسند.

- عامل های خودمختار (Autonomous Agents): شبکه های عصبی دیگر فقط پاسخ نمی دهند؛ خودشان هدف تعیین می کنند، ابزار انتخاب می کنند و پروژه های چندمرحله ای را بدون دخالت انسان انجام می دهند (مانند AutoGPT در ۲۰۲۳، ولی در سطح واقعی).

- ادغام با سخت افزار زیستی و کوانتومی: Neuralink و شرکت های مشابه تا ۲۰۳۰ رابط مغز−کامپیوتر تجاری خواهند داشت. همزمان، کامپیوترهای کوانتومی اولین مدل های ترکیبی کوانتومی−عصبی را اجرا می کنند.

- شخصی سازی کامل: هر فرد یک مدل اختصاصی ۱۰ تا ۱۰۰ میلیارد پارامتری خواهد داشت که فقط روی داده های زندگی خودش آموزش دیده و حریم خصوصی کامل دارد (Federated Learning + On-device).

- تولید جهان های شبیه سازی شده: موتورهای بازی و متاورس تا ۲۰۳۰ کاملا با Diffusion و NeRFهای پیشرفته تولید خواهند شد؛ دیگر طراح انسانی لازم نیست.

در نهایت، سال ۲۰۳۰ سالی خواهد بود که مرز بین هوش مصنوعی و هوش انسانی محو می شود. قابلیت آموزش شبکه های عصبی باعث شده، امروزه نه فقط ابزار، بلکه شریک فکری و خلاق ما باشند. کسانی که امروز پایه های قوی می سازند، فردا معماران این آینده خواهند بود.

آموزش شبکه های عصبی چگونه انجام می شود؟

آموزش شبکه های عصبی شبیه تربیت یک کودک بسیار باهوش اما بی تجربه است. شما به او میلیون ها مثال نشان می دهید و هر بار که اشتباه می کند، به او می گویید «کمی این طوری بهتر است». این فرآیند در دنیای شبکه های عصبی با نام «Backpropagation» یا «انتشار معکوس» شناخته می شود.

در هر مرحله آموزش، شبکه یک پیش بینی می کند، خطایش با تابع هزینه (Loss Function) محاسبه می شود و سپس این خطا به عقب برگردانده می شود تا وزن های هر نورون به مقدار بسیار کمی تغییر کند. این تغییر وزن با کمک الگوریتم های بهینه سازی مثل SGD، Adam یا RMSprop انجام می شود. نکته ی جالب اینجاست که تمام این محاسبات در اصل مشتق گیری زنجیره ای از یک تابع بسیار بزرگ و پیچیده است؛ چیزی که بدون کارت های گرافیک مدرن عملا غیرممکن بود.

امروزه کتابخانه هایی مثل TensorFlow، PyTorch و JAX این فرآیند را به شدت ساده کرده اند. شما فقط مدل را تعریف می کنید، داده را می دهید و بقیه اش را فریم ورک انجام می دهد. البته هنوز هم هنر یک محقق یادگیری عمیق در تنظیم هایپرپارامترها، طراحی Loss مناسب و جلوگیری از بیش برازش (Overfitting) نهفته است.

کتاب هایی برای یادگیری شبکه های عصبی

اگر پس از خواندن این مقاله مشتاق شدید که خودتان دست به کار شوید، شبکه های عصبی کتاب هایی برای یادگیری بهتر این مبحث دارد که عبارتند از:

- Deep Learning نوشته ی Ian Goodfellow و همکاران (کتاب مرجع و کمی سنگین)

- Neural Networks and Deep Learning نوشته ی Michael Nielsen (رایگان و بسیار روان)

- Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow نوشته ی Aurélien Géron (بهترین برای شروع عملی)

- Dive into Deep Learning (d2l.ai) — کتاب تعاملی و رایگان با کدهای آماده

شبکه های عصبی دیگر فقط یک شاخه ی دانشگاهی نیستند؛ آن ها موتور محرک تمدن بعدی ما هستند. در واقع هرچه بیشتر یاد بگیریم، آیندهی روشن تری خواهیم ساخت. اگر به هر دلیل، دسترسی به این کتاب ها برایتان دشوار است؛ جای نگرانی نیست، پلتفرم هوش مصنوعی اکیان بستری ساده و سریع برای یادگیری مبحث شبکه های عصبی برایتان فراهم کرده است.

۱۰ اشتباه رایج هنگام یادگیری شبکه های عصبی

بسیاری از افرادی که وارد دنیای یادگیری شبکه های عصبی می شوند، با وجود انگیزه بالا، ماه ها یا حتی سال ها درجا می زنند. دلیلش نه کمبود هوش، بلکه افتادن در تله های تکراری است. این ۱۰ اشتباه، شایع ترین دام هایی هستند که بیش از ۹۰٪ مبتدیان تجربه می کنند:

- شروع مستقیم با مدل های خیلی بزرگ بسیاری به جای یک شبکهٔ ۳ لایه ای ساده، مستقیم سراغ ResNet-152 یا LLaMA می روند و چون داده و سخت افزار کافی ندارند، ناامید می شوند.

- نادیده گرفتن پایه های ریاضی گرادیان، مشتق زنجیره ای و ماتریس ها را «بعداً یاد می گیرم» می گذارند و بعد در درک Backpropagation قفل می کنند.

- کپی کردن کد بدون فهم کد آماده از گیت هاب اجرا می شود، دقت ۹۹٪ می دهد، اما فرد نمی داند چرا یک لایه را حذف کند مدل خراب می شود.

- استفاده از دیتاست های خیلی کوچک یا کثیف با ۲۰۰ عکس گربه و سگ شروع می کنند و تعجب می کنند که چرا مدل بیش برازش می کند.

- فراموش کردن Normalization و Data Augmentation ساده ترین راه افزایش دقت ۱۰–۲۰٪ را نادیده می گیرند.

- تنظیم نکردن Learning Rate از مقدار پیش فرض استفاده می کنند و یا مدل منفجر می شود یا اصلا یاد نمی گیرد.

- ارزیابی فقط با Accuracy در مسائل نامتعادل (مثل تشخیص سرطان) دقت ۹۹٪ می گیرند اما Recall فقط ۳۰٪ است.

- تمرین نکردن Debugging وقتی Loss به NaN می رسد، فقط مدل را دوباره اجرا می کنند به جای ریشه یابی.

- نخواندن مقاله های اصلی فقط ویدیو می بینند و هیچ گاه paperهای Transformer، CNN یا Diffusion را باز نمی کنند.

- تنها یادگیری، بدون پروژه واقعی بدون ساختن حتی یک برنامه کاربردی، رزومه خالی می ماند و انگیزه کم می شود.

اجتناب از این ۱۰ اشتباه، می تواند سرعت یادگیری شما را تا ۵ برابر افزایش می دهد.

یادگیری شبکه های عصبی با پلتفرم هوش مصنوعی اکیان

هوش مصنوعی، خودش قابلیت آموزش از مقدماتی تا حرفه ای شبکه های عصبی را دارد. البته هر هوش مصنوعی توانایی هایی منحصر به فردی برای آموزش و ایجاد بستری برای تمرین و یادگیری دارد. در حال حاضر، اکیان تنها پلتفرم هوش مصنوعی فارسی در ایران است که دسترسی یکپارچه و همزمان به پیشرفته ترین مدل های جهان، شامل GPT-4o، Grok، Gemini، Claude و DeepSeek را در یک محیط واحد فراهم می کند.

این امکان به شما اجازه می دهد تا در فرآیند یادگیری شبکه های عصبی و یادگیری عمیق، از توانایی های تخصصی هر مدل به بهترین شکل بهره مند شوید؛ از توضیحات دقیق و گام به گام GPT-4o برای درک مفاهیم پیچیده ی Backpropagation و Transformer، تا تحلیل عمیق کدهای PyTorch و TensorFlow توسط Grok، یا طراحی پروژه های عملی با راهنمایی Gemini و Claude می توانید از این پلتفرم ت خصصی، استفاده کنید. مدل های زبانی بزرگی مثل GPT، Gemini و LLaMA همگی از طریق در این پلتفرم در دسترس شما قرار گرفته است.

با استفاده از اکیان، دیگر نیازی نیست بین مدل های مختلف هوش مصنوعی، جابه جا شوید یا منابع پراکنده را جستجو کنید؛ تمام ابزارهای مورد نیاز برای یادگیری حرفه ای شبکه های عصبی، از آموزش نظری تا پیاده سازی عملی، در یک پلتفرم متمرکز و فارسی زبان در دسترس شماست. برای آغاز یادگیری موثر و یکپارچه، کافیست روی لینک زیر کلیک کرده و تجربه ای متفاوت از آموزش هوش مصنوعی را شروع کنید: